Flink是一个由Apache软件基金会开发的开源流处理框架,其核心是一个用Java和Scala编写的分布式流数据流引擎。Flink能够在无界数据流和有界数据流上进行有状态的计算,具有实时性,且能够在常见的集群环境中运行,并以内存速度和任意规模进行计算。

Flink的主要特性包括:

- 批流一体:Flink从另一个视角看待流处理和批处理,将二者统一起来。流处理看待时输入数据流是无界的,而批处理被作为一种特殊的流处理,只是其输入数据流被定义为有界的。

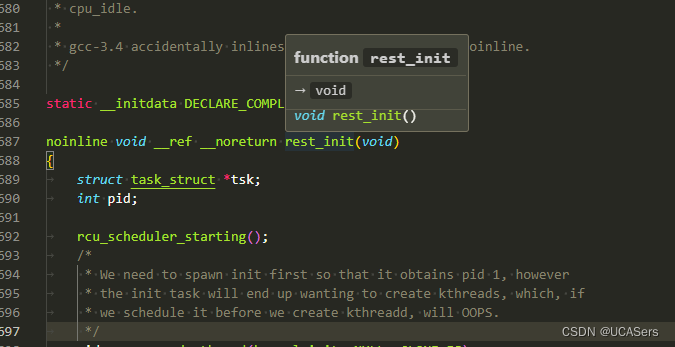

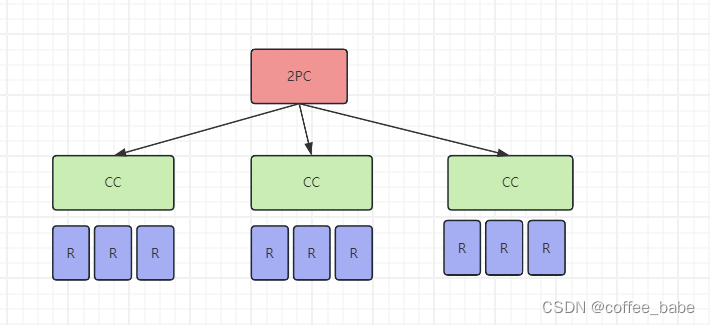

- 精确一致性(Exactly-Once):Flink通过实现两阶段提交和状态保存来实现端到端的精确一致性语义。

- 状态管理:Flink在做计算的过程中经常需要存储中间状态,以避免数据丢失和状态恢复。

- 容错和恢复:Flink具有轻量级的容错机制,允许系统在高吞吐率的同时提供仅一次的一致性保证。当发生故障时,启用了检查点的Flink程序将从上一个完成的检查点恢复处理,确保数据的一致性。

- 灵活的窗口处理:Flink支持灵活的基于时间窗口、计数或会话数据驱动的窗口。

- 高吞吐量和低延迟:Flink能够处理大量的数据,并且延迟非常低。

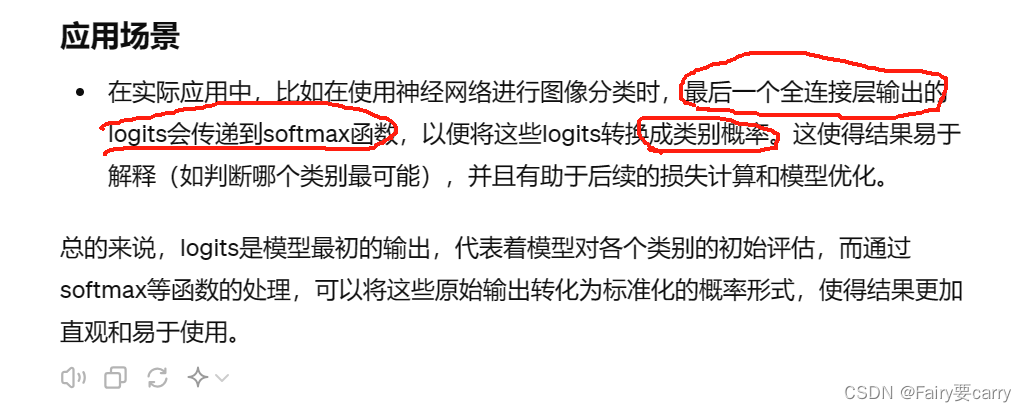

Flink的应用场景广泛,包括实时数据计算、实时数据仓库和ETL、事件驱动型场景(如告警、监控)等。随着Flink对机器学习的支持越来越完善,它还可以被用作机器学习和人工智能的一部分。

核心特性

- 高吞吐和低延迟:Flink具有出色的性能,能够每秒处理数百万个事件,并且具有毫秒级的延迟。这使得它非常适合处理实时数据流,如实时日志分析、实时用户行为跟踪等。

- 精确的状态一致性保证:Flink提供了“精确一次”(Exactly-Once)的状态一致性保证,确保在发生故障时,数据不会丢失或重复处理。它通过分布式快照和状态恢复机制来实现这一点。

- 灵活的窗口处理:Flink支持基于时间、计数或会话的窗口操作,使得用户能够轻松地对数据流进行复杂的分析和计算。

- 强大的容错和恢复能力:Flink具有轻量级的容错机制,能够在发生故障时快速恢复并继续处理数据。它还支持动态扩展和收缩集群,以适应不同规模的数据处理需求。

应用场景

Flink适用于各种实时数据处理和分析场景,包括但不限于:

- 实时数据分析:Flink可以实时处理和分析来自各种数据源的数据,如网站点击流、传感器数据等。它支持复杂的计算逻辑和多种数据格式,可以生成实时的统计报告、仪表板和告警通知。

- 实时数据仓库和ETL:Flink可以用作实时数据仓库的组成部分,将实时数据流与离线数据相结合,提供全面的数据分析功能。它还可以用于ETL(Extract, Transform, Load)过程,将数据从源系统提取、转换并加载到目标系统中。

- 事件驱动型应用:Flink非常适合构建事件驱动型应用,如实时告警、实时监控等。当特定事件发生时,Flink可以触发相应的处理逻辑,并生成实时响应。

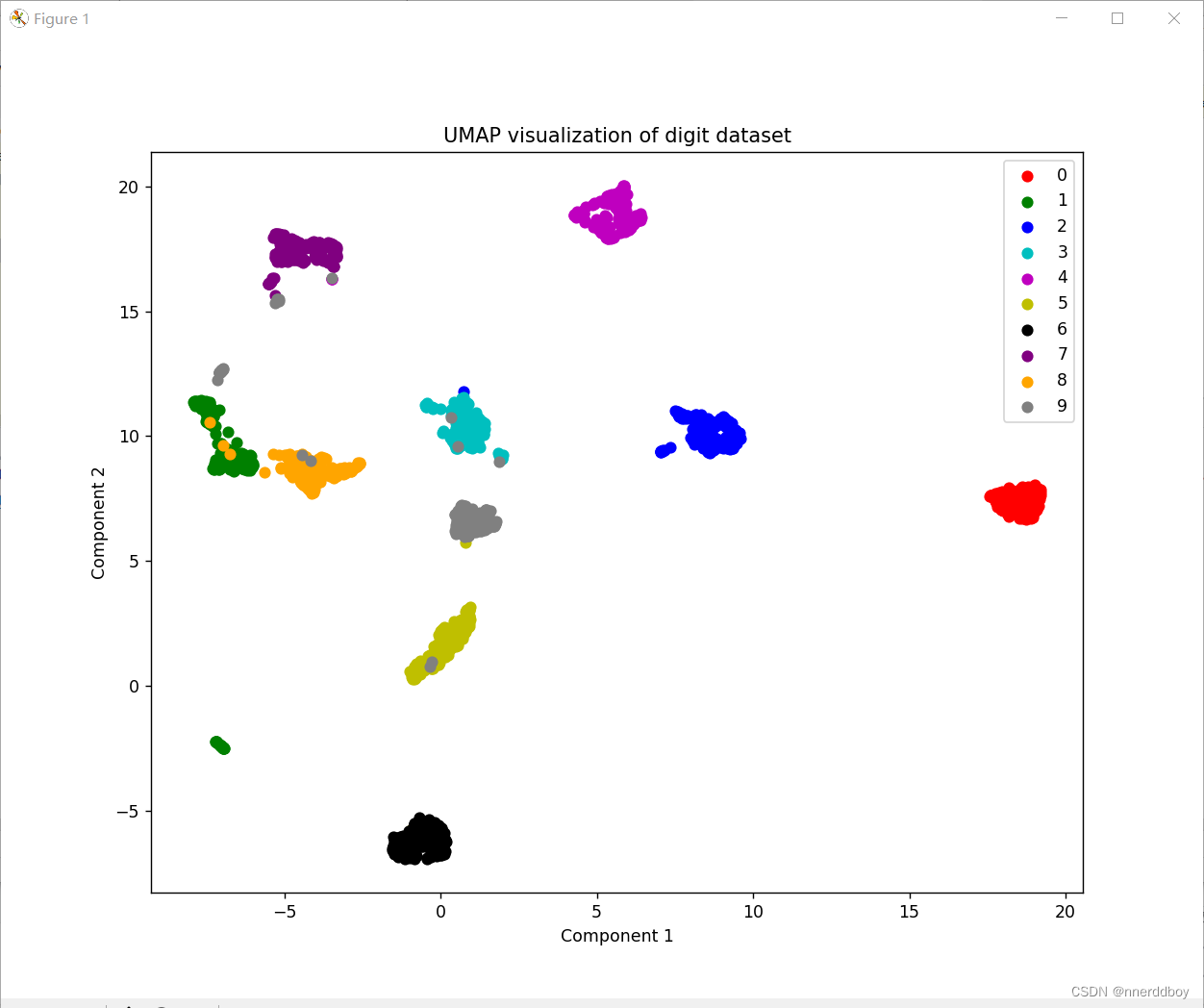

- 机器学习:随着Flink对机器学习的支持越来越完善,它还可以用于构建基于实时数据的机器学习应用。通过实时分析用户行为、交易数据等,可以训练模型并生成预测结果。

架构和组件

Flink的架构主要包括以下几个组件:

- JobManager:负责接收客户端提交的作业(Job),并将其调度到TaskManager上执行。它还负责作业的协调、资源分配和故障恢复等任务。

- ResourceManager:负责集群资源的分配和管理,如CPU、内存和磁盘空间等。它与TaskManager进行交互,确保它们有足够的资源来执行作业。

- TaskManager:是Flink的工作进程,负责执行具体的任务(Task)。它接收JobManager的调度指令,并启动相应的线程来执行任务。TaskManager还会将心跳和统计信息报告给JobManager。

- Client:用于提交作业到Flink集群的客户端程序。它可以是命令行工具、Web界面或API调用等。

与Hadoop的对比

与Hadoop相比,Flink在实时数据处理方面具有显著的优势。Hadoop使用批处理模式,不适合处理实时数据流。而Flink支持流处理和批处理模式,可以实现更高效的实时数据处理。此外,Flink还具有更高的灵活性和更低的延迟,使得它成为实时数据处理领域的佼佼者。然而,Flink的生态系统和社区支持相对较弱,部署和维护也相对复杂一些。

综上所述,Apache Flink是一个功能强大、性能卓越的分布式流处理框架,适用于各种实时数据处理和分析场景。通过深入了解其核心特性、应用场景和架构组件,我们可以更好地利用它来构建高效、可靠的实时数据处理系统。